-

-

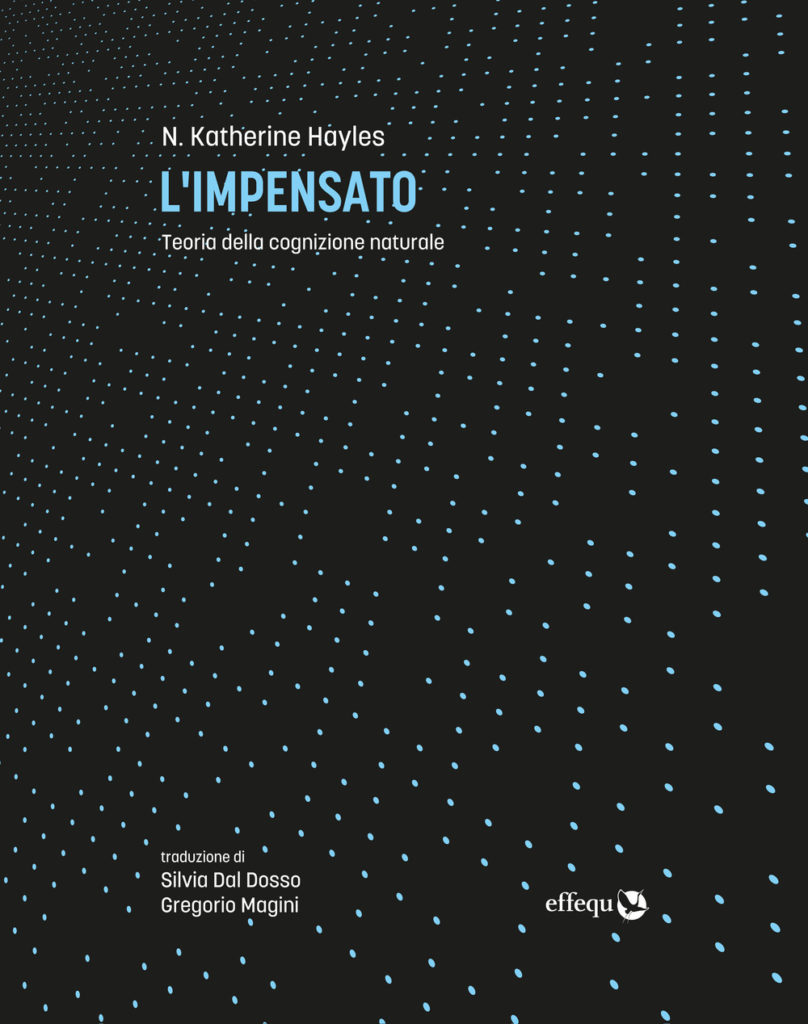

L’impensato. Intervista a N. Katherine Hayles

Longform / Aprile 2022La seguente intervista a N. Katherine Hayles è stata organizzata in occasione della pubblicazione dell'edizione italiana di Unthought The Power of the Cognitive Nonconscious per l'editore Effequ. Studiosa di fama internazionale, direttrice e docente del programma di letteratura presso la Duke University ha fornito un contributo fondamentale al rapporto tra letteratura, scienza e tecnologia. Nel suo ultimo saggio l’autrice pone al centro della riflessione un ripensamento radicale della nozione di cognizione, soprattutto attraverso l’elaborazione dei concetti di cognizione non conscia e assemblaggi cognitivi. Tra le sue pubblicazioni ricordiamo How We Became Posthuman: Virtual Bodies in Cybernetics, Literature and Informatics, uscito nel 1999 ma ancora oggi riferimento imprescindibile per chi si occupa di postumanesimo e di posthumanities.

Intervista di Ambra Lulli

Traduzione di Alice Iacobone

Ambra Lulli: Vorrei cominciare facendo un confronto tra il tuo nuovo libro L’impensato e i tuoi lavori meno recenti. In particolare, ho notato che nel L’impensato non viene mai utilizzata la nozione di postumano. Che rapporto c’è tra la riflessione che sviluppi in questo nuovo testo sulla cognizione non conscia e sugli assemblaggi cognitivi e quella sull’interazione tra esseri umani e tecnologia che avevi portato avanti in How We Became Posthuman? Ritieni che le nozioni di postumano e postumanesimo possano essere ancora delle categorie d’analisi critica interessanti o la loro assenza nel tuo nuovo testo indica piuttosto la necessità di un loro superamento?

N. Katherine Hayles: Come sapete, i Posthuman studies sono oggi in una fase molto avanzata e contano dozzine di libri, riviste e raccolte sul tema. Insieme a molti altri autori, considero le categorie di postumanesimo e postumano come d’importanza vitale per l’analisi critica. Al centro del mio interesse per il postumano, iniziato ormai più di vent’anni fa, c’era l’idea che tecnologie computazionali come la realtà virtuale stessero decostruendo il soggetto umanista liberale. Questo processo oggi è in uno stadio ancor più avanzato. Per come lo avevo concepito allora, il postumano non implicava necessariamente un ripensamento delle forme di vita non umane. Gli importanti lavori di Donna Haraway, Cary Wolfe, Timothy Morton e altri hanno reso chiaro che il postumano, come movimento, dovrebbe incidere (e di fatto incide) anche sulle nostre relazioni con altre specie. Se ne L’impensato non menziono il postumano in maniera esplicita è perché il concetto è semplicemente assunto come precursore di nozioni centrali quali l’idea della cognizione nonconscia, dell’emergenza di media computazionali come nostri simbionti contemporanei, dell’importanza degli assemblaggi cognitivi per la vita attuale nelle società sviluppate.

AL: Partiamo dall’inizio del tuo nuovo libro. In particolare, vorrei soffermarmi sul modo in cui inviti a ripensare la cognizione, come sostanzialmente distinta dal pensiero, e in un modo che porta ad estendere questa facoltà a tutte le forme di vita biologiche e a molti sistemi tecnici. In che modo, il ripensamento da te proposto, se da un lato intende avvicinare cognizione umana e tecnica, dall’altro vuole prendere le distanze dal modello cognitivista che interpreta la cognizione come computazione? Inoltre, vorrei soffermarmi sulla nozione di informazione a cui fai riferimento quando proponi questa ridefinizione della cognizione: un “processo che interpreta l’informazione in contesti che la connettono con il significato” (p.45). Mi sembra importante notare che la nozione di informazione a cui fai riferimento si distanzia da quella puramente quantitativa e probabilistica proposta da Shannon e Weaver, per rimanere invece legata a nozioni quali quelle di significato e di interpretazione. Potresti soffermarti anche su questo punto e approfondire la nozione di informazione a cui fai riferimento? Nel testo vengono citati autori come Friedkin e Simondon.

NKH: Fondamentalmente, il paradigma cognitivista affermava che il cervello umano opera come un computer. Io penso invece che questo sia altamente improbabile, considerate le profonde differenze tra media computazionali e cervelli umani dal punto di vista dell’incarnazione [embodiment]. La mia preferenza personale va ai modelli di cognizione incarnata o incorporata, come quelli elaborati da Maturana e Varela in Autopoiesis and Cognition, da Thompson, Varela e Rosch in The Embodied Mind, da Edwin Hutchins in Cognition in the Wild, da Lawrence Barsalou nel suo lavoro sulla “grounded cognition”, per menzionarne solo alcuni. Se certamente sostengo che sia umani che computer abbiano capacità cognitive, d’altra parte però insisto anche sull’importanza della loro diversa incarnazione, che implica maniere differenti di realizzare tali funzioni cognitive. È anche per questo che ho deciso di concentrare la mia ricerca sulla cognizione invece che su, ad esempio, pensiero o intelligenza, nozioni dotate di una lunga storia che le associa esclusivamente all’essere umano. La definizione di cognizione che citate la connette a interpretazione e significato. Sono termini forti nelle discipline umanistiche, e li ho scelti in parte per questa ragione; tuttavia, li uso in una maniera che supera radicalmente le concezioni tradizionali, che storicamente hanno attribuito solo agli esseri umani il diritto di performare l’attività interpretativa e l’attività di significazione. Prendendo le mosse dalla biosemiotica, sostengo che tutti gli esseri biologici, incluse piante e organismi unicellulari, interpretano informazione dai propri ambienti in maniere che sono significative per le loro vite. Come notate, questo uso del termine “informazione” non è lo stesso di quello del concetto promosso da Shannon e Weaver; piuttosto, si avvicina alla “differenza che fa una differenza” di Gregory Bateson e alla nozione di individuazione elaborata da Simondon.

AL: I nuovi materialismi sembrano utilizzare un lessico “deleuziano” (i concetti di forze, affetti, intensità e assemblaggi contingenti) per sottolineare soprattutto il carattere dinamico e profondamente trasformativo della materialità. In questo quadro il soggetto e la cognizione, di cui queste proposte teoriche vorrebbero fare a meno, si configurano come elementi unicamente “conservativi”. Nel quadro teorico da te proposto, e attraverso l’introduzione della nozione di cognizione non-conscia, quale potenziale trasformativo viene affidato invece alla cognizione? Si può sostenere che, attraverso il ripensamento della nozione di cognizione che proponi, è possibile considerare la complessità come il prodotto di azioni/ dinamiche cognitive?

NKH: Dal mio punto di vista, il carattere trasformativo della materialità ha indubbiamente agency, basti pensare a fenomeni che vanno dalla lenta erosione delle rocce fino alle violente eruzioni dei vulcani. Per questo parlo delle forze materiali nei termini di agenti. Ciò che le forze materiali non possono fare, tuttavia, è interpretare l’informazione che viene dai loro ambienti e basare le loro azioni su tali interpretazioni. L’eruzione di un vulcano, le roboanti fratture di una valanga, la violenta formazione di un uragano si possono comprendere come la somma totale delle forze rilevanti che agiscono in quel momento. Queste forze non possono decidere di seguire un percorso differente – di aspettare che gli sciatori abbiano abbandonato le piste, ad esempio, o di investire un campo deserto invece che una città affollata. Manca loro la capacità di selezione e scelta, funzioni che tutte le forme di vita hanno, persino le più umili. In breve, le forze materiali sono agenti ma non attori, precisamente perché mancano di capacità cognitive. Gli organismi certamente hanno una propensione per l’aspetto “conservativo” nella misura in cui mirano a perpetuare la propria esistenza. Tutto lo studio dell’omeostasi è un tributo a questa idea, un’indagine dei modi in cui i corpi viventi si stabilizzano in ambienti in mutamento. Senza dubbio è per questo che Deleuze e Guattari dichiararono che i loro scritti erano contro l’organismo, il segno, il soggetto. Allo stesso tempo, però, gli organismi possono essere infinitamente creativi, come la storia dell’evoluzione ci mostra. Le rocce possono essere compresse o frantumate, traslate o fratturate, ma non possono essere altro che rocce. Gli esseri viventi, al contrario, costantemente divengono altro da ciò che sono, creando nuove cellule mentre quelle vecchie muoiono, producendo nuovi anticorpi per combattere le malattie, inventando nuovi comportamenti al mutare delle condizioni. Più un organismo è dotato di capacità cognitive, più sarà capace di invenzioni radicali. Gli esseri umani sono ovviamente il massimo emblema di questa affermazione, ma anche altre specie esibiscono notevoli capacità di trasformare sé stesse e i propri ambienti, basti pensare ai casi in cui un albero sviluppa una tossina specifica contro un parassita mai incontrato prima. Quando molteplici attori interagiscono gli uni con gli altri nel proprio ambiente, invariabilmente si ottengono delle dinamiche complesse. Questi attori non sono necessariamente dotati di coscienza, possono anche fare uso di cognizione nonconscia. Inoltre, anche per gli esseri umani, la cognizione nonconscia svolge funzioni cruciali affinché la coscienza possa operare. Dal mio punto di vista, la cognizione nonconscia rende conto della maggior parte della cognizione umana, incluse quelle funzioni spesso date per scontate come mantenere una rappresentazione corporea coerente, adattare postura e respiro alle condizioni presenti, rispondere a segni e segnali sotto la soglia della coscienza, coordinare stati emotivi e attenzione.

AL: Quali sono le implicazioni del decidere di utilizzare la nozione di “assemblaggio cognitivo” piuttosto che di rete? Mi sembra che parlare di assemblaggio ci consenta di evitare la reificazione delle interconnessioni tra agenti, considerando gli assemblaggi sempre appunto come “provvisori”, ma al tempo stesso la differenza sta nel tipo di “materialità” coinvolta. Gli assemblaggi, a differenza delle reti, sembrano fare riferimento a una materialità “carnale”, tridimensionale, che oppone resistenza e che ha a che fare con il “toccare, il respingere e il mutare” (p. 209). Potresti approfondire questo punto?

NKH: Come suggerite, un assemblaggio è più flessibile e transitorio di una rete, il che lo rende una scelta migliore dal mio punto di vista. Gli assemblaggi cognitivi sono collettività che includono umani, non umani e media computazionali, che interagiscono tutti grazie alle loro capacità cognitive. Un esempio potrebbe essere quello di quando parli al cellulare, ad esempio al tuo cane quando sei via da casa: qui si uniscono la tua cognizione, le capacità computazionali del telefono e ovviamente il tuo cane, quando inclina la testa in quel suo modo grazioso. Quando chiudi la chiamata e vai al computer, entri in un altro assemblaggio che coinvolge la macchina, le connessioni di rete, un server remoto e così via. Entrando in automobile sei in un altro assemblaggio ancora, che comprende le capacità computazionali dell’auto, i sensori della strada, i tempi dei semafori, eccetera. Come Giano, gli assemblaggi cognitivi hanno due facce. Una faccia è rivolta verso il flusso dell’informazione, l’altra verso la materialità degli enti dell’assemblaggio, ovvero le loro qualità “carnali” (per ciò che riguarda gli enti biologici) e le loro istanziazioni in metallo e silicone (nel caso dei media computazionali). L’incarnazione determina il modo in cui si dà il flusso d’informazione, per questo non possiamo comprendere l’aspetto astratto senza prendere in considerazione il lato materico.

AL: Con la nozione di assemblaggi cognitivi, sembri soprattutto voler sottolineare la situazione di densa embricazione e simbiosi, di interazione e comunicazione ormai pervasive tra cognizione umana e sistemi tecnici. La cognizione tecnica sembra avere un ruolo cruciale nelle nostre forme di vita (si pensi, ad esempio, alle cognizioni tecniche a cui è interamente affidata la gestione del traffico in una città come Los Angeles) e conseguenze enormi sulle società e le culture umane. La prospettiva sembra quindi essere quella di una coevoluzione, di una relazione simbiotica in cui per ognuno dei simbionti coinvolti risulta impossibile pensare di prosperare senza l’altro. A quali differenti visioni politiche ed etiche portano una concezione, come la tua, che sottolinea la stretta interdipendenza tra cognizioni umane e tecniche, rispetto a una concezione che considera plausibile per il soggetto umano la possibilità di “svincolarsi” dalla fitta rete di cognizioni tecniche che costituiscono la sua ecologia cognitiva? La pervasività della cognizione tecnica e la sempre maggiore autonomia dei media computazionali si associa a forme di controllo sempre più efficaci, con i problemi e i costi che queste implicano. Di fronte a questa prospettiva, non si dovrebbe forse poter pensare alla possibilità di “interrompere” o “disturbare” il flusso continuo di informazioni e di comunicazione? Non si dovrebbe, cioè, pensare il rapporto tra esseri umani e sistemi tecnici anche in termini di conflitto oltre che di simbiosi?

NKH: Tecnicamente, la definizione biologica di simbiosi comprende anche il parassitismo e altre forme di associazione distruttiva. I sistemi tecnici possono indubbiamente essere causa sia di conflitto che di simbiosi. Pensiamo all’operaio lasciato a casa perché un robot industriale ha preso il suo posto in fabbrica, o all’accusato che viene incarcerato ingiustamente invece di essere messo in libertà vigilata perché un algoritmo responsabile delle condanne reputa probabile che sarebbe un recidivo. Dal mio punto di vista, ci sono molti casi in cui dovrebbero essere gli umani, e non gli algoritmi, a prendere le decisioni. Ma dobbiamo anche tenere a mente che pure gli umani sono lungi dall’essere infallibili e sono portatori di pregiudizi espliciti ed impliciti. Per me, la maggiore differenza tra decisioni algoritmiche e giudizio umano rimane quella evidenziata da Hubert Dreyfus quasi cinquant’anni fa: gli esseri umani hanno una più ampia e comprensiva visione del mondo. In realtà, si potrebbe dire con Dreyfus che noi abbiamo un mondo, mentre gli algoritmi hanno solo dati immessi al loro interno. Nei dibattiti contemporanei c’è un gran numero di voci che esortano all’interruzione e all’alterazione, a volte mostrando una scarsa comprensione di cosa i computer realmente fanno. Sono d’accordo sul fatto che questa sia spesso una tattica necessaria, ma penso anche che sia ugualmente importante mettere in atto tattiche e strategie di decostruzione dell’antropocentrismo, compresa la convinzione che gli umani siano superiori ed abbiano il diritto di dominare su tutto il resto, anche sulle altre specie e sulle intelligenze artificiali. Data l’urgenza della crisi ambientale attuale, ci occorrono diversi modi di concepire il mondo e la nostra relazione con esso. Abbandonare l’antropocentrismo è un modo per conseguire questo obiettivo. Lo sostituirei con ciò che chiamo “reciprocità ecologica”, evidenziando le relazioni tra gli esseri umani, i viventi non umani e i media computazionali.

AL: Parlando degli algoritmi di trading automatizzato, metti in luce come l’operare della cognizione tecnica in questo caso avvenga sfruttando temporalità inaccessibili alla cognizione cosciente, e come ciò costituisca un’ “ecologia cognitiva algoritmica di sole macchine”. I modi in cui gli umani possono interagire con queste ecologie di sole macchine, in modo da correggerle secondo criteri etici (penso, ad esempio, all’andamento dei mercati finanziari) hanno più a che fare con l’intervento in quelli che definisci “punti di flesso”, piuttosto che con la regolamentazione. Si tratta di un’opzione di controllo “debole” su processi che rimangono fondamentalmente ingovernabili, contrapposta all’idea di un controllo “forte”? In che modo tutto ciò ci porta a un necessario ripensamento del paradigma cibernetico, che vedeva nei cicli di feedback la chiave per il controllo e l’autocontrollo delle tecnologie cognitive? Sembra che i cicli di feedback di cui parlava la cibernetica abbiano assunto le sembianze di cicli ricorsivi in grado di generare grande complessità e impredicibilità, trasformando gli ambienti in cui queste tecnologie cognitive operano in ambienti fortemente instabili, potenzialmente soggetti a rapide rotture e crisi improvvise.

NKH: Non sono contraria alla regolamentazione, ma tutto dipende dal tipo di regolamentazione proposta e da quali conseguenze, desiderate e indesiderate, essa potrebbe avere. Nel capitolo sugli algoritmi di trading discuto alcune proposte di riforma del processo di trading automatizzato che operano non attraverso la regolamentazione governativa, che si è dimostrata inefficace o addirittura controproducente, ma attraverso il cambiamento delle condizioni in cui si effettuano le transazioni, ad esempio rallentandole intenzionalmente. Immagino che questo si possa chiamare “controllo debole”, ma non sono sicura di come potrebbe configurarsi un “controllo forte” – forse nel modo in cui la Cina gestisce i propri mercati azionari? Come sapete, i cicli di retroazione [feedback loop] del paradigma cibernetico possono essere sia negativi, tendendo ad attenuare e bilanciare le oscillazioni nel sistema, o positivi, accentuando le fluttuazioni fino al punto di rottura. Nei sistemi biologici, si danno entrambi i tipi di feedback loop. Probabilmente un qualche tipo di equilibrio tra i due è necessario per qualsiasi sistema complesso, sia esso biologico o tecnico. La troppa stasi e creatività è repressa; un’eccessiva fluttuazione e l’intero sistema potrebbe collassare. Il trucco è trovare la giusta combinazione che possa portare a trasformazioni positive.

AL: La contingenza e l’imprevedibilità sembrano avere, nel tuo libro, anche un potenziale liberatorio: ciò emerge soprattutto nei capitoli 7 e 8, quando esplori il potenziale utopico degli assemblaggi cognitivi. Come “inconoscibile”, la contingenza al cuore degli assemblaggi cognitivi è al centro della tua interessante analisi del romanzo L’intuizionista di Colson Whitehead. Scegliendo come chiavi di lettura per interpretare il romanzo il problema dell’arresto di Turing e i problemi di incompletezza di Godel, l’ “inconoscibile” e il “non computabile” sembrano investiti della speranza in un futuro più giusto. Potresti soffermarti su questo punto e spiegarci meglio in che modo intendi questo potenziale utopico e liberatorio degli assemblaggi cognitivi?

NKH: Il mondo reale è costellato di contingenze e eventi imprevedibili, che possono essere sia liberatori che devastanti – un vento può permettere al navigante di entrare in porto o può essere così violento da strappare via le case. Nei mondi artificiali dei media computazionali la contingenza e l’imprevedibilità devono invece essere integrate, con un’importante eccezione. Come M. Beatrice Fazi evidenzia, l’impossibilità dimostrata da Turing di trovare una soluzione generale al problema dell’arresto – ovvero, il fatto che non si possa prevedere in anticipo se un determinato algoritmo si fermerà o se verrà eseguito per sempre – apre uno spazio per la contingenza persino entro le operazioni apparentemente deterministiche di un computer. Fazi mette questa contingenza computazionale in relazione con il virtuale di Deleuze e le occasioni reali di Whitehead. Persino le reti neurali non sfuggono al problema dell’arresto, perché ancora lavorano attraverso astrazioni computazionali che cercano di sistematizzare gli aspetti della realtà. È stato mostrato che il teorema di Gödel e il problema dell’arresto sono interconvertibili (cioè, partendo da uno qualunque dei due, l’altro può essere inferito da esso). Lo stesso Gödel ha sottolineato che le limitazioni articolate nei due teoremi si riferiscono solo ai sistemi formali (ad esempio, ai sistemi aritmetici) e non al pensiero umano in sé, che secondo lui potrebbe spaziare liberamente in regioni in cui la computazione non arriva (per come la mette Turing, i numeri incommensurabili). È interessante notare come nel suo articolo del 1936 sul problema dell’arresto, Turing abbia provato che l’insieme dei numeri computabili ha la stessa dimensione dell’insieme dei numeri naturali o contabili. Entrambi sono molto più piccoli dell’insieme dei numeri reali, che è più ampio di vari ordini di grandezza. Da questo punto di vista, il campo del computabile è molto più piccolo del campo del pensabile (per gli umani). Gli esseri umani possono inventare i computer, ma i computer non possono inventare gli esseri umani.

AL: Sembra che il potenziale utopico del non-conscio cognitivo abbia il significato, per te, anche di una “speranza” che riguarda il futuro degli studi umanistici. In particolare, sembri auspicare la possibilità per gli studi umanistici, grazie all’introduzione del non-conscio cognitivo, di uscire dall’isolamento che li caratterizza, e di poter invece cominciare ad apportare decisivi contributi a discipline scientifiche quali ad esempio l’informatica, l’ingegneria elettrica, l’architettura o perfino l’economia. Quali sono esattamente, secondo te, le poste in gioco etiche e politiche di questa ibridazione disciplinare e di questa riarticolazione dei rapporti tra saperi all’insegna della profonda interazione e necessaria interdipendenza? Ciò richiederebbe agli studi umanistici una conversione dei propri paradigmi talmente profonda da poter essere considerata una vera e propria “rottura epistemica”, come tu stessa sostieni. C’è anche qualcosa che potrebbe andare perso per gli studi umanistici, in termini di capacità di incidere sul nostro presente e futuro, all’interno di questa nuova ecologia disciplinare?

NKH: Le scienze si interrogano sempre sul “cosa?” e spesso sul “come?”, ma solo molto raramente si domandano “perché?” o “che cosa significa questo?”. Tradizionalmente queste domande sono appannaggio degli studi umanistici, con lunghe e ricche tradizioni in filosofia, scienze delle religioni, letteratura, etica, e altre discipline. Con l’espansione costante della tecnosfera, le domande legate al “perché?” e al “dovremmo?” (distinte da quelle come “saremmo in grado?”) stanno diventando sempre più urgenti. Gli studiosi di discipline umanistiche hanno la competenza e la conoscenza necessarie per produrre importanti contributi su questi temi. Alcune aree degli studi umanistici che sono in rapida espansione, come gli Animal studies e le Environmental Humanities, hanno già offerto contributi importanti per l’avanzamento in ambito tecnico e scientifico, spaziando dalla gestione degli animali di laboratorio a una più profonda comprensione dell’importanza delle relazioni ecologiche in generale. Tuttavia, gli umanisti devono anche comprendere che intervenire in ambito tecnico e scientifico realizzando interazioni efficaci ha il suo prezzo. Come gli attivisti contro l’AIDS hanno presto capito, interventi riusciti con protocolli tecnici e scientifici richiedono di apprendere le basi del campo d’interesse. La comunicazione richiede un lessico comune, o almeno una zona d’intersezione linguistica. Sono convinta che l’interazione coi saperi tecnici e scientifici contribuirebbe anche a creare un atteggiamento di scetticismo da parte delle discipline umanistiche nei confronti dei loro stessi eccessi, il che dal mio punto di vista avrebbe effetti benefici. In questa prospettiva ci sono dunque vantaggi per le scienze e le tecnologie nel relazionarsi con le discipline umanistiche e vantaggi per le discipline umanistiche nel confrontarsi con le scienze e le tecnologie. Perché non dovremmo volerlo?

Intervista di Ambra Lulli

Traduzione di Alice Iacobone

-

Bruno Latour. Essere di questa terra

Recensioni / Giugno 2020Per chi voglia avvicinarsi agli ultimi sviluppi delle scienze sociali e della filosofia, la lettura di Bruno Latour è una tappa cruciale da molti anni ormai. Testi come Non siamo mai stati moderni (elèuthera, Milano 1995) o Politiche della Natura (Raffaello Cortina, Milano 2000) sono presenze fondamentali nelle bibliografie di chi si muove, per esempio, nelle environmental humanities o nel campo del postumano. Sarebbe però riduttivo limitare l’influenza di Latour a questi settori disciplinari, non solo per la difficoltà di assegnare i suoi scritti a una regione del sapere chiara e distinta. Attorno alle opere di Latour si sono affollati artisti, curatori, designer, architetti ed esponenti delle scienze dure. La grande fortuna di Latour mostra la dismisura della nostra fame di saperi ibridi, bastardi, capaci di attraversare più ambiti disciplinari. Gli scritti di Latour sono animati da un doppio movimento: da un lato, lo sguardo si posa fedele su alcuni grandi autori del canone filosofico occidentale come Heidegger e Schmitt, con un approccio che talvolta rasenta la filologia – o addirittura l’esegetica biblica, il primo ambito di specializzazione accademica scelto da Latour; dall’altro, le mani sono indaffarate in una pratica di pensiero tutta contemporanea, impegnate a lambiccare in un laboratorio entro il quale i concetti e i problemi più impellenti del pianeta vengono trattati come reagenti instabili.

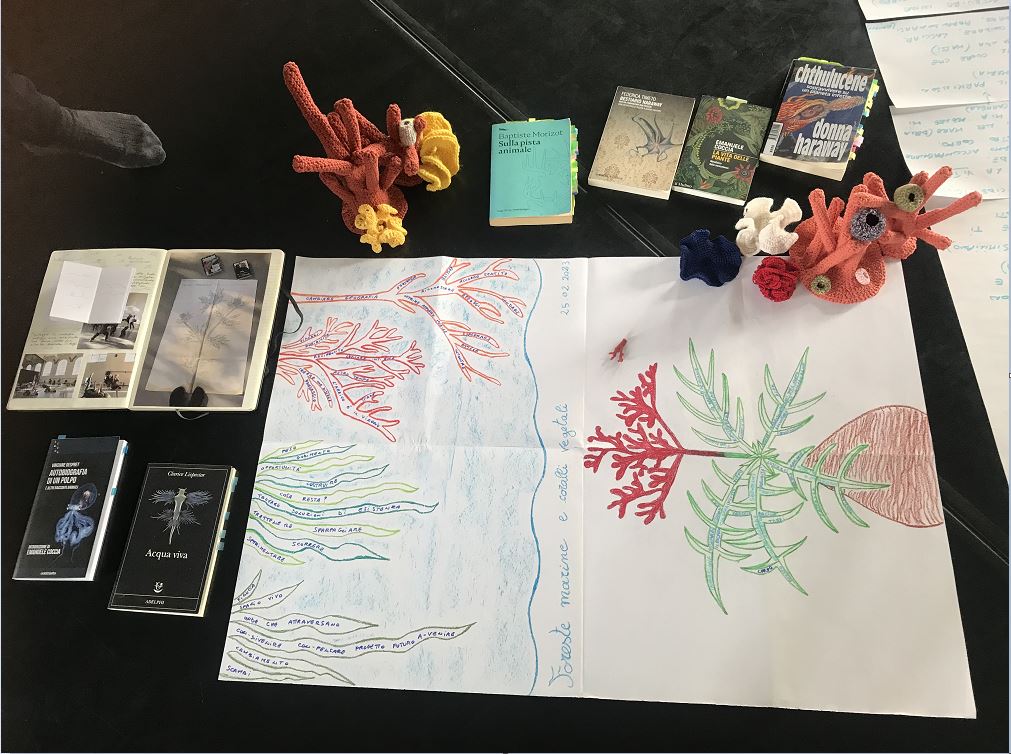

Essere di questa terra. Guerra e pace al tempo dei conflitti ecologici (Rosenberg & Sellier, Torino 2019) costituisce un eccellente punto di ingresso in questo antro alchemico, questa zona di sperimentazione. Il calderone di Latour si versa qui in 5 articoli che illustrano lo sviluppo del suo pensiero dal 1995 al 2013: a Modernizzare o ecologizzare. Alla ricerca della settima città (1995) seguono Perché la critica ha finito il carburante. Dalle matters of fact alle matters of concern (2004), L’Antropocene e la distruzione dell’immagine del globo (2013) e infine Guerra e pace al tempo dei conflitti ecologici (2013). La brillante introduzione di Nicola Manghi mette a fuoco il criterio con cui questi materiali sono stati raccolti in un’unica antologia. Il fil rouge di queste indagini di Latour consiste nel «rapporto di forte continuità che gli studi di ecologia politica hanno con le ricerche di sociologia della scienza e "antropologia dei Moderni" precedentemente condotte» (p. 7). La ricostruzione storica proposta prende le mosse dagli studi sulla costruzione della competenza condotti da Latour ad Abidjan, la capitale della Costa d’Avorio, mostrando come essi conducano all’etnografia della vita di laboratorio che farà di Latour uno degli autori cardine dell’antropologia del pensiero scientifico. Tuttavia, nella produzione recente di Latour i riferimenti cambiano. I nuovi protagonisti sono due personaggi concettuali, Gaia e l’Antropocene, alternativi a concetti quali Natura e Modernità. Da un lato, nella concettualizzazione inventata da James Lovelock, Gaia è quel complesso mosaico di entità in costante e imprevedibile negoziato fra loro che materializzano su scala planetaria gli effetti dell’evoluzione della vita sulla Terra. Questo tempo evolutivo profondo si solidifica in un’opera di costruzione collettiva di mondi a cui hanno preso e prendono parte tutte le specie viventi; dall’altro, l’Antropocene trasforma la portata dell’agency umana depositandola in tracce geostoriche, prodotte come eccesso involontario dei sogni moderni di un perfetto controllo dell’ambiente da parte della specie umana.

Gaia e l’Antropocene danno nuovo alimento a una delle missioni principali di Latour, la riconcettualizzazione dei rapporti fra scienza e società, fra natura e politica. Secondo Latour, la Modernità pensava di poter descrivere queste dicotomie concettuali considerando i loro termini reciprocamente autonomi, purificando tutte quelle entità ibride situate sulle frontiere fra i due domini. Latour propone piuttosto di ricondurre naturale e sociale a quell’ampia zona di indistinzione metamorfica in cui essi risiedono prima di essere depurati in una serie di binomi. Entro questa riconfigurazione dei rapporti costituzionali fra gli agenti, anche le scienze assumono un volto ben diverso. Ben lungi dal disincantamento weberiano, i saperi scientifici sono piuttosto pratiche di avventurosa moltiplicazione degli attori che compongono i nostri mondi. Pensare le scienze come operazioni di riduzione o meccanizzazione degli enti è un’allucinazione che appartiene solo alle autodescrizioni dei Moderni e che descrive male la natura pratica del lavoro scientifico. Se gli si rivolge uno sguardo etnografico, le scienze diventano processi di esplorazione di mondi brulicanti di agenti, sistemi per tracciare cartografie di reti cosmologiche. Agli occhi di Latour la conoscenza scientifica è dunque un’attività di continua costruzione dei fatti, ma questa pratica inventiva non è appannaggio esclusivo degli umani. Gli agenti della costruzione dei fatti scientifici vanno ben oltre alla concettualizzazione Moderna della “società”. Gli scienziati non sono i soli soggetti attivi nelle loro ricerche. I loro laboratori non sono luoghi in cui gli enti sono oggetti passivi, messi a completa disposizione, ma spazi di incontro fra umani e cose, mediatori indocili e mai del tutto controllabili, capaci di sgusciare dalle procedure di controllo per intraprendere corsi di azione imprevedibili.

L’articolo che inaugura l’antologia – Modernizzare o ecologizzare? – è un accesso insolito a Latour, ma chiarisce molti degli approcci e dei temi trattati negli anni successivi. Una domanda fondamentale lo guida: data la difficoltà con cui i partiti ecologisti si muovono nell’arena democratica, l’ecologia può essere sciolta in altre sfere del politico? In altre parole, i problemi e i conflitti che sorgono dalla natura possono essere ridotti a questioni di carattere amministrativo o economico? Latour riformula il problema. Il quesito è mal posto perché si richiama a una concezione dell’ecologia relativa a una natura staccata dal corpo sociale, universale ma passiva. In questo senso, l’ecologia si riduce a una serie di contenuti discreti che hanno a che vedere con le difficoltà che talvolta sorgono da un mondo senza umani, che si tratterebbe di tutelare, amministrare o utilizzare come risorsa. Latour propone invece di concettualizzare l’ecologia non come contenuto, ma come processo trasversale che attraversa in modo diffuso tutto l’ambito del politico. Compiuta questa riconcettualizzazione, ecologizzare il politico non significherà quindi tinteggiare di verde gli stendardi lasciando inalterati i corsi d’azione politici, ma «creare le procedure che permettano di seguire un insieme di quasi-oggetti i cui legami di subordinazione rimangono incerti e che obbligano dunque a un’attività politica di tipo nuovo che sia adatta a monitorarli» (p. 61).

Latour propone un aggiornamento concettuale analogo anche in Perché la critica ha finito il carburante? Secondo Latour la pur fondamentale eredità dello sguardo critico rischia di aggravare un già irrespirabile clima di sfiducia generalizzata. I maestri del sospetto sono diventati maestri della paranoia, complottisti sofisticati che dietro a ogni fenomeno vedono agitarsi le ombre titaniche di una serie di antagonisti dalle iniziali in maiuscolo: il Capitalismo, la Tecnoscienza, e così via. Latour conosce bene lo scenario che dipinge perché è stato ascritto alle fila dei suoi agitatori. Entro le science wars – animate fra gli altri da Alain Sokal – la sua antropologia delle scienze era stata considerata l’ennesimo colpo di maglio inferto alla struttura pericolante della fiducia pubblica nel discorso scientifico. Agli occhi dei critici di Latour, dire che i fatti scientifici sono costruiti implica che le scienze mentano, che inventino in modo arbitrario la realtà. Latour va in tutt’altra direzione. La missione di Latour è cosmopolitica, per dirla con Isabelle Stengers. Per Latour, «il critico non è colui che smaschera, ma colui che assembla» (p. 90), che intraprende un faticoso lavoro di composizione di un mondo comune. Non si tratta dunque di demolire i saperi, ma di rallentare la velocità con cui essi costruiscono le proprie unità di senso per risalire ai reticolati e alle assemblee di agenti che li rendono possibili.

Questo lavoro di montaggio e manutenzione di mondi tuttavia comporta dei rischi. Gli ultimi tre articoli si concentrano sugli scossoni epistemologici ed esistenziali assestati da Gaia e dall’Antropocene. La diagnosi di Latour è chiara: in un’epoca di catastrofi quotidiane, di ordinaria sommossa geostorica, gli strumenti offerti dalla Modernità sono ormai ferrivecchi quasi inservibili. «Nel modernismo, le persone non sono equipaggiate con un repertorio mentale ed emozionale adeguato ad affrontare eventi di una simile scala» (pp. 97-98). Non si tratta solo di conoscere meglio: i saperi affrontano inedite sfide di carattere affettivo, entro le quali la posta in gioco è anche l’elaborazione di nuove storie capaci di fornire alla specie umana delle tecniche della presenza, degli scafandri in grado di reggere l’insostenibile pressione ambientale odierna e a venire. Latour lo afferma con James Lovelock e Peter Sloterdijk: il compito è immunologico. Dobbiamo costruire membrane in grado di proteggerci dai capricci di una Gaia irritata e vendicativa. La natura meccanomorfa e indifferente dei Moderni è impraticabile, Gaia e l’Antropocene ci costringono ad assumere una forma di pur debole animismo, a pensare i viventi nonumani e le cose come vivi e attivi: «uno dei principali enigmi della storia dell’Occidente non è tanto che ‘vi siano popoli che ancora credono nell’animismo’, quanto la credenza, piuttosto ingenua, che molti continuano tuttavia a coltivare, in un mondo disanimato fatto di mera materia – e questo proprio nel momento in cui sono essi stessi a moltiplicare le agency, con le quali si trovano ogni giorno più intrecciati. Più ci addentriamo nella geostoria, e più questa credenza sembra difficile da capire» (p. 105).

Gaia, a differenza della Natura a cui eravamo abituati, non può essere dominata perché non può essere osservata dall’esterno, nel sorvolo offerto da una posizione trascendente e disincarnata. Gaia non è una figura di unificazione, non è un ambito di sintesi, un magnete capace di attrarre a nuovo consenso tutti i popoli della terra. Gaia è il nome di un processo in atto, non di un fondamento; con Gaia ci manca la terra sotto ai piedi. Gaia non è neppure raffigurabile come una sfera, un globo, una totalità intera; la sua immagine è piuttosto l’intrico di un grande numero di anelli e di onde d’azione che agiscono e retroagiscono diffondendo i propri effetti in maniera imprevedibile. Interagire con Gaia significa quindi muoversi a tentoni, provando a intercettarla e seguirla con il maggior numero di strumenti possibili. Fra questi strumenti ci sono anche le epistemologie, le storie che i saperi raccontano.

Di quali storie e immagini ha bisogno questo spaesamento generalizzato? Per Latour occorrono narrazioni ed esperienze che consentano di sviluppare «una fusione lenta e progressiva di virtù cognitive, emozionali ed estetiche, ottenuta grazie a mezzi tramite cui gli anelli si fanno sempre più visibili – strumenti e forme d’arte di ogni sorta. A ogni anello, diventiamo più sensibili e più reattivi ai fragili involucri che abitiamo» (p. 143). Questo addestramento a nuove arti dell’immaginazione e dell’attenzione è forse uno dei compiti più preziosi di chi voglia impegnarsi, oggi, a rovistare fra le rovine dei discorsi e delle pratiche che abbiamo ereditato, per sperimentare nuovi bricolage e per provare a inventare tesori costruiti con rottami.

.

di Dario Bassani

.

-

Tim Ingold – Making. Una ecologia del produrre

Recensioni / Maggio 2019 Potremmo pensare che filosofi e artigiani facciano due mestieri molto diversi, che hanno davvero poco a che vedere l’uno con l’altro: il primo infatti pensa, scrive e parla mentre il secondo fa, produce e manipola. Forse proprio per questo è poco usuale, per i filosofi, interrogarsi sul nesso tra la loro attività abituale, il pensiero, e il fare che segna tanto il lavoro dell’artigiano quanto la più comune prassi quotidiana. Ed è forse altrettanto poco usuale per un operaio o un artigiano chiedersi in che modo, nella sua attività di produzione, egli stia anche pensando. Eppure si tratta di una questione straordinariamente feconda, ci insegna Tim Ingold nel suo Making, prima opera dell’autore ad essere interamente tradotta in italiano a cura di Gesualdo Busacca per Raffaello Cortina (Milano, 2019, pp. 262). Il testo scaturisce dall’esperienza di un corso universitario tenuto da Ingold a partire dal 2004 nella facoltà di Antropologia dell’università di Aberdeen, intitolato: Le quattro A: Antropologia, Archeologia, Arte e Architettura. Più volte ripreso e messo da parte nel corso degli anni, Making esce per la prima volta nel 2013 e riprende l’ossatura teorica di Being alive (2011), la raccolta di saggi in cui si sviluppa un originale percorso teorico mosso dall’esigenza di riavvicinare l’antropologia alla vita. Ciò che però contraddistingue Making, rispetto a questa raccolta, è l’intimo legame che la riflessione intrattiene con l’esperienza al contempo didattica e di ricerca dell’insegnamento universitario. Ingold intende spingersi ben oltre la trasmissione di nozioni ridotte a rappresentazioni astratte, ferme e chiuse; è piuttosto interessato a coinvolgere i suoi studenti in percorsi di movimento nell’ambiente che aprano ad esso in un atteggiamento di ascolto ed esplorazione. Il gruppo si educa così a una forma di attenzione percettiva che permette di porsi sulle tracce delle cose che abitano il mondo tramite una paziente e scrupolosa raccolta di indizi. Gli studenti, infatti, erano chiamati non solo a seguire lezioni frontali, ma soprattutto a cimentarsi in esperienze di manipolazione di materiali e costruzione di oggetti nel corso di esperimenti e laboratori collettivi sempre accompagnati da momenti di restituzione e discussione. Le quattro A intrecciava dunque attività di produzione ed elaborazione riflessiva, facendole scaturire come momenti di una conoscenza trasformativa che si innesta sui percorsi vitali delle cose e si sviluppa con essi. Questo lavoro dà origine alla pratica di formazione collettiva nella quale prendono corpo le idee che animano il libro. Nell’ambito di un corso universitario, volto comunemente a produrre tramite il pensiero, Ingold e i suoi studenti imparano ad imparare in un altro modo, ossia a pensare tramite il produrre.

Potremmo pensare che filosofi e artigiani facciano due mestieri molto diversi, che hanno davvero poco a che vedere l’uno con l’altro: il primo infatti pensa, scrive e parla mentre il secondo fa, produce e manipola. Forse proprio per questo è poco usuale, per i filosofi, interrogarsi sul nesso tra la loro attività abituale, il pensiero, e il fare che segna tanto il lavoro dell’artigiano quanto la più comune prassi quotidiana. Ed è forse altrettanto poco usuale per un operaio o un artigiano chiedersi in che modo, nella sua attività di produzione, egli stia anche pensando. Eppure si tratta di una questione straordinariamente feconda, ci insegna Tim Ingold nel suo Making, prima opera dell’autore ad essere interamente tradotta in italiano a cura di Gesualdo Busacca per Raffaello Cortina (Milano, 2019, pp. 262). Il testo scaturisce dall’esperienza di un corso universitario tenuto da Ingold a partire dal 2004 nella facoltà di Antropologia dell’università di Aberdeen, intitolato: Le quattro A: Antropologia, Archeologia, Arte e Architettura. Più volte ripreso e messo da parte nel corso degli anni, Making esce per la prima volta nel 2013 e riprende l’ossatura teorica di Being alive (2011), la raccolta di saggi in cui si sviluppa un originale percorso teorico mosso dall’esigenza di riavvicinare l’antropologia alla vita. Ciò che però contraddistingue Making, rispetto a questa raccolta, è l’intimo legame che la riflessione intrattiene con l’esperienza al contempo didattica e di ricerca dell’insegnamento universitario. Ingold intende spingersi ben oltre la trasmissione di nozioni ridotte a rappresentazioni astratte, ferme e chiuse; è piuttosto interessato a coinvolgere i suoi studenti in percorsi di movimento nell’ambiente che aprano ad esso in un atteggiamento di ascolto ed esplorazione. Il gruppo si educa così a una forma di attenzione percettiva che permette di porsi sulle tracce delle cose che abitano il mondo tramite una paziente e scrupolosa raccolta di indizi. Gli studenti, infatti, erano chiamati non solo a seguire lezioni frontali, ma soprattutto a cimentarsi in esperienze di manipolazione di materiali e costruzione di oggetti nel corso di esperimenti e laboratori collettivi sempre accompagnati da momenti di restituzione e discussione. Le quattro A intrecciava dunque attività di produzione ed elaborazione riflessiva, facendole scaturire come momenti di una conoscenza trasformativa che si innesta sui percorsi vitali delle cose e si sviluppa con essi. Questo lavoro dà origine alla pratica di formazione collettiva nella quale prendono corpo le idee che animano il libro. Nell’ambito di un corso universitario, volto comunemente a produrre tramite il pensiero, Ingold e i suoi studenti imparano ad imparare in un altro modo, ossia a pensare tramite il produrre.